Nvidia şu sıralar hızla yükseliyor. Şirket son 10 yılda çiplerinin yapay zeka görevlerindeki performansını bin kat artırmayı başardı ve para basıyor.

Nvidia buraya nasıl geldi?

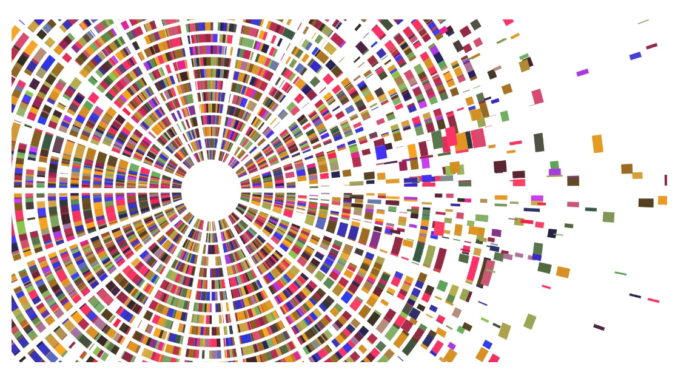

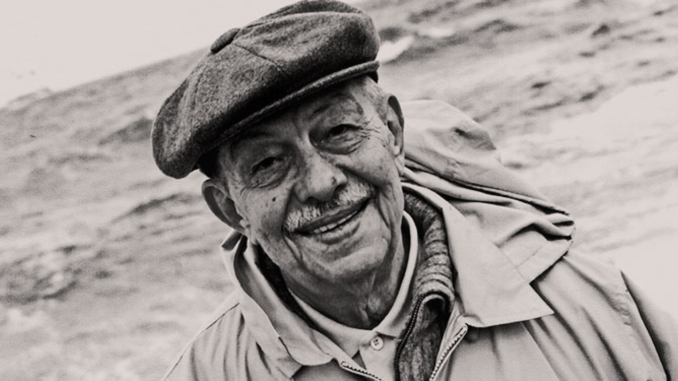

Şirketin baş bilim insanı Bill Dally, geçen hafta Silikon Vadisi’nde yüksek performanslı mikroişlemciler üzerine düzenlenen IEEE’nin Hot Chips 2023 sempozyumunda yaptığı açılış konuşmasında her şeyi tek bir slaytta özetlemeyi başardı. Moore Yasası Nvidia’nın sihrinin şaşırtıcı derecede küçük bir parçasıydı ve yeni sayı formatları çok büyük bir parçasıydı. Hepsini bir araya getirdiğinizde Dally’nin Huang Yasası (Nvidia CEO’su Jensen Huang için) dediği şeyi elde edersiniz.

Nvidia baş bilim insanı Bill Dally, Nvidia’nın yapay zeka görevlerinde GPU’larının performansını 10 yıl içinde nasıl bin kat artırdığını özetledi.

Dally ve ekibinin, daha az bitten daha fazla yapay zeka elde etmek için her türlü ilginç fikri var. Ve kayan nokta sisteminin ideal olmadığı açık. Temel sorunlardan biri, kayan nokta doğruluğunun sayı ne kadar büyük ya da küçük olursa olsun oldukça tutarlı olmasıdır. Ancak sinir ağları için parametreler büyük sayıları kullanmaz, sıfırın hemen etrafında kümelenirler. Bu nedenle, Nvidia’nın Ar-Ge odağı, sayıları temsil etmenin verimli yollarını bulmaktır, böylece sıfıra yakın daha doğru olurlar.

Sayı Temsili: 16x

Nvidia’nın en büyük kazancı, daha iyi bir sayı temsili kullanmaktan geldi. Özellikle, şirketin GPU’ları, yapay zeka görevlerinde daha hızlı ve daha verimli olabilmek için daha az hassas sayılar kullanıyor. Örneğin, Nvidia’nın en yeni GPU’su H100, 8-bit sayılar kullanarak büyük dönüşüm yapabilen yapay sinir ağları gibi görevleri gerçekleştirebiliyor.

Karmaşık Talimatlar: 12.5x

Nvidia, GPU’larını büyük hesaplamaları tek bir talimatta gerçekleştirecek şekilde tasarlıyor. Bu, karmaşık talimatların enerji maliyetinin yalnızca matematiksel işlemlerin enerji maliyetinin %16’sı olduğu anlamına geliyor.

Moore Yasası: 2.5x

Moore Yasası, Nvidia’nın GPU kazançlarının yalnızca küçük bir kısmından sorumlu. Şirket, en gelişmiş üretim teknolojisini kullandı ve H100 modeli TSMC’nin N5 (5 nanometre) süreci ile üretildi.

Seyreklik: 2x

Nvidia, yapay sinir ağlarını “seyrek” hale getirerek hesaplama yükünü azaltıyor. Bu, ağdaki birçok nöronun aslında orada olmasına gerek olmadığı anlamına geliyor.

NVIDIA’nın başarısının arkasında yatan diğer önemli konular

Nvidia, yapay zeka (AI) alanında dünyanın önde gelen şirketlerinden biri. Peki bu başarının arkasında ne yatıyor? Bu sorunun cevabını bulmak için, Nvidia’nın AI teknolojilerini nasıl geliştirdiğine ve kullandığına yakından bakalım.

Nvidia’nın AI başarısının temelini, grafik işlem birimleri (GPU) oluşturuyor. GPU’lar, bilgisayar grafikleri için tasarlanmış yüksek performanslı işlemcilerdir. GPU’lar, çok sayıda küçük ve basit işlemci çekirdeğine sahiptir. Bu çekirdekler, paralel olarak çalışarak, büyük ve karmaşık veri setlerini hızlı bir şekilde işleyebilirler.

GPU’lar, AI uygulamaları için de idealdir. Çünkü AI uygulamaları, genellikle derin öğrenme (deep learning) adı verilen bir yöntem kullanır. Derin öğrenme, çok katmanlı yapay sinir ağları (artificial neural networks) ile verilerden özellikleri ve modelleri otomatik olarak öğrenmeyi sağlar. Derin öğrenme, çok sayıda matematiksel işlem gerektirir. Bu işlemler, GPU’lar tarafından paralel olarak yapıldığında, çok daha hızlı ve verimli olur.

Nvidia, GPU’larını AI için optimize etmek için çok çalıştı. Şirket, CUDA adı verilen bir programlama arayüzü geliştirdi. CUDA, GPU’ların AI uygulamaları için kolayca programlanmasını sağlar. Ayrıca, Nvidia, AI geliştiricileri için çeşitli yazılım araçları ve kütüphaneleri de sundu. Bunlardan bazıları şunlardır:

– TensorRT: Derin öğrenme modellerini optimize eden ve hızlandıran bir platform.

– cuDNN: Derin sinir ağları için temel işlevleri sağlayan bir kütüphane.

– RAPIDS: Büyük veri analizi ve makine öğrenimi için GPU tabanlı bir çerçeve.

– Jarvis: Konuşma tanıma ve doğal dil işleme için bir uçtan uca çözüm.

Nvidia’nın sunduğu bu araçlar sayesinde, AI geliştiricileri, GPU’ların gücünden faydalanarak, daha hızlı ve daha iyi sonuçlar elde edebiliyorlar. Nvidia’nın GPU’ları, hem bulut hem de kenar (edge) ortamlarında çalışabiliyor. Bu da AI uygulamalarının daha geniş bir alanda yaygınlaşmasını sağlıyor.

Nvidia’nın AI başarısının bir diğer boyutu da, kendi AI uygulamalarını geliştirmesi ve sunmasıdır. Nvidia, kendi derin öğrenme modellerini eğitmek için devasa bir veri merkezi kurdu. Bu veri merkezi, Nvidia’nın Selene adını verdiği süper bilgisayarını barındırıyor. Selene, dünyanın en hızlı beşinci süper bilgisayarıdır.

Nvidia, Selene’i kullanarak, çeşitli alanlarda AI uygulamaları geliştirdi. Bunlardan bazıları şunlardır:

– GAN: Generative adversarial networks adı verilen bir yöntemle, gerçekçi görüntüler üreten bir sistem.

– Maxine: Video konferanslarda yüz ifadelerini iyileştiren ve bant genişliğini azaltan bir platform.

– Omniverse: Sanal gerçeklikte ortak çalışmayı sağlayan bir simülasyon ortamı.

– Clara: Tıbbi görüntüleme ve analiz için bir platform.

Nvidia’nın geliştirdiği bu AI uygulamaları, hem kendi müşterilerine hem de genel olarak AI topluluğuna fayda sağlıyor. Nvidia, AI uygulamalarını açık kaynak olarak paylaşıyor. Böylece, diğer geliştiriciler de bu uygulamalardan yararlanabiliyor veya geliştirebiliyorlar.

Nvidia’nın AI başarısının sırrı, kısaca, GPU’larını AI için optimize etmesi, AI geliştiricilerine kolaylık sağlayan araçlar sunması ve kendi AI uygulamalarını geliştirmesi ve paylaşmasıdır. Nvidia, bu sayede, AI alanında lider bir konuma gelmiştir.

Şirket, AI teknolojilerini sürekli geliştirmeye ve yeniliklere açık olmaya devam ediyor.

Kaynak: